Deep Learning Reconstructionの新たな展開

平井 俊範(熊本大学大学院生命科学研究部 放射線診断学講座)

Session(2) : MRI

2023-6-26

近年,人工知能(AI)の社会実装が進んでおり,医療の分野においても盛んに研究が行われている。MRIに関しては,SNR向上技術としてDeep Learning Reconstruction(DLR)が注目されており,MRIに関するDLRの論文数も右肩上がりで増加している。このような状況の中,熊本大学では,2018年からフランス・ボルドー大学およびキヤノンメディカルシステムズとの共同研究として「Advanced intelligent Clear-IQ Engine(AiCE)」の研究を開始し,2020年から「Hybrid DLR」,2022年からは「Precise IQ Engine(PIQE)」の研究が進行中である。本講演では,これら3つの研究の概要を報告する。

Advanced intelligent Clear-IQ Engine(AiCE)

AiCEは,低SNRな画像のノイズを除去し,高SNRな画像に変換する技術である。コントラストに寄与する低周波成分は除外し,高周波成分であるノイズのみをDeep Learningで学習させることで,低SNRの画像からノイズを除去して,高SNRの画像として出力する。

通常,画質を改善するためには加算回数を多くする必要があるが,当院における頭部のT2強調画像(T2WI)を用いた検討では,ノイズの多い2回加算の画像にAiCEを適用することで,5回加算と同等の高画質が得られた1)。FLAIRやMPRAGEの画像でも同様の結果であった1)。また,AiCEによって画質が改善することで,例えば高分解能heavily T2WIの3D MR cisternographyでは,conventional画像と比較して脳神経が明瞭となるほか2),1.5TのTOF-MRAでは眼動脈などの微細な血管の描出能が向上する3)。

以上を踏まえ,AiCEの利点は,(1) ノイズを特異的に除去する,(2) さまざまな部位や多くの撮像シーケンスで使用可能,(3) 再構成時間が比較的短い,(4) k空間データのunder-samplingを利用した高速化手法〔SPEEDER,Compressed SPEEDER(CS),Fast 3D modeなど〕とも併用可能,であると言える。なお,ここでは(4) をHybrid DLRと呼称し,以下にその概要を述べる。

Hybrid DLR

脳下垂体のT2WIを,CS factor:2.4,撮像時間1分8秒で撮像し,CSを単独で適用した画像とHybrid DLR(AiCE with CS)を適用した画像を比較したところ,Hybrid DLRの方が明らかにSNRが向上していた4)。

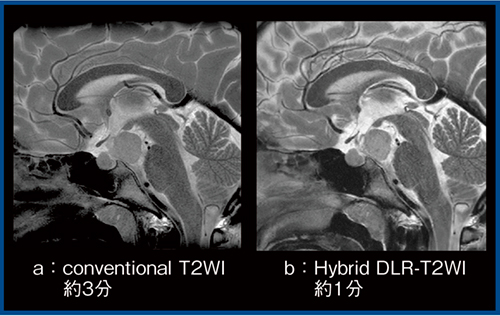

図1は視床下部に過誤腫のある症例のT2WIであるが,約3分で撮像したconventional画像(a)と比較し,約1分で撮像したHybrid DLR(AiCE with CS)の画像(b)の方が,灰白隆起や漏斗部の構造がはるかに明瞭に描出されている。

そのほか,中大脳動脈瘤の症例において,撮像時間4分40秒のconventional TOF-MRAと,撮像時間1分26秒のTOF-MRAにHybrid DLR(AiCE with Fast 3D mode)を適用した画像を比較したところ,微小な動脈瘤がほぼ同等に描出されていた。右内頸動脈閉塞の症例において,撮像時間4分40秒で統一したconventional MRAと,高分解能Hybrid DLR(AiCE with Fast 3D mode)適用MRAを比較したところ,眼動脈や前大脳動脈の末梢,中大脳動脈の末梢はHybrid DLRの画像が最も明瞭であり,ノイズが低減され高いSNRが得られていた。また,自己免疫性膵炎症例のMRCPでは,呼吸同期撮像の画像と,呼吸停止下撮像でAiCE非適用および適用の画像を比較したところ,AiCEを適用した画像では,肝内胆管が呼吸同期撮像の画像と同等に描出されていた5)。

以上を踏まえ,Hybrid DLRの利点は,(1) k空間データのunder-samplingを利用した高速化手法(PI,CS,Fast 3D mode)とも併用可能,(2) それに伴い,高速化 / 高分解能化+AiCEでノイズ低減 / SNR向上が期待できる,(3) 多くの撮像部位やシーケンスで使用可能,(4) 再構成時間が比較的短い,であると言える。

図1 視床下部過誤腫症例のT2WIにおけるconventionalとHybrid DLRの比較

Precise IQ Engine(PIQE)

1.PIQEの概要

超解像技術であるPIQEは,単位長さあたりのピクセル数を高める技術で,空間分解能を9倍まで向上することができる。ノイズが多く,分解能がやや低い画像にPIQEを適用することで,高SNR・高解像画像の取得が可能となる。

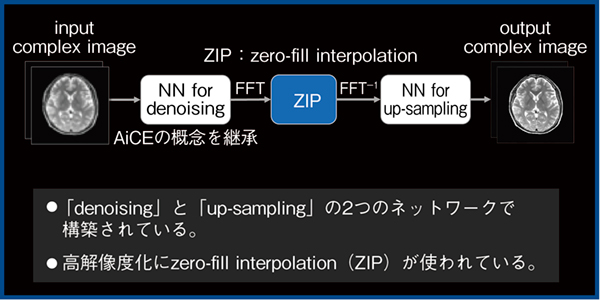

PIQEは,denoisingとup-samplingの2つのネットワークで構築されている(図2)。まず,AiCEと同様にノイズを低減した後,zero-fill interpolation(ZIP)を用いて高分解能化を行う。ZIPは,k空間上の高周波成分にゼロを充填することで,擬似的に見た目の解像度を向上させる手法であるが,問題点として,若干のボケが残存し,リンギングアーチファクトが発生する。これを,Deep Learningを用いて高解像度のシャープな画像に戻すup-samplingによって除去することで高解像度化を図る。つまり,PIQEでは,denoisingとup-samplingにDeep Learningを用いることで,汎用性と安定性を図るよう構築されている。

図2 PIQEの概要

2.PIQEの活用

通常,MRIにおいては,空間分解能とSNRおよびコントラストはトレードオフの関係にあるが,PIQEを用いることで高コントラストと高空間分解能を両立できる可能性がある。

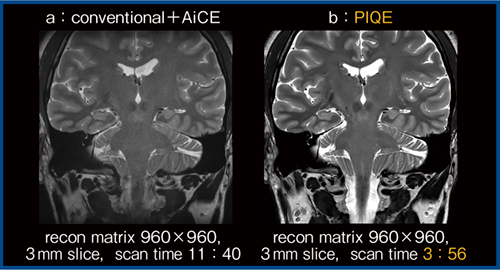

図3は,960×960マトリックス,3mmスライス厚の高分解能T2WI冠状断像であるが,撮像時間11分40秒のconventional+AiCEの画像(a)と比較し,撮像時間3分56秒のPIQEの画像(b)の方がSNRがきわめて高く,コントラストも非常に良好であり,7T装置にも匹敵すると思われる高画質が得られている。

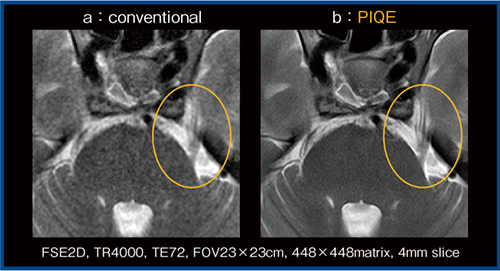

図4は,448×448マトリックスのT2WI横断像の一部を拡大している。conventional画像(a)では不明瞭なメッケル腔内の三叉神経の分枝(〇)が,PIQEの画像(b)では明瞭であり,きわめて高空間分解能であることがわかる。

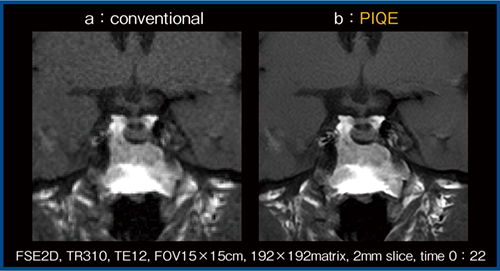

図5は,192×192マトリックス,2mmスライス厚,22秒で撮像したT1強調ダイナミックスタディ条件の下垂体の画像である。PIQEを用いることでSNR,解像度が大幅に向上しており(b),PIQEは今後,ダイナミックスタディにきわめて有望であると考える。

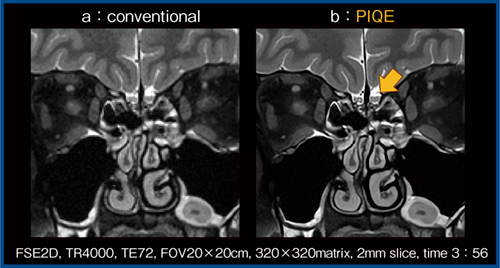

図6は眼窩および副鼻腔のfat-sat T2WIであるが,PIQEにて嗅神経がきわめて明瞭に描出されている(b)。さらに,眼窩内の外眼筋,視神経,上眼静脈などの構造物や副鼻腔の粘膜および鼻粘膜も高精細に描出されており,今後,PIQEの頭頸部領域への応用が期待される。

図3 高分解能T2WIにおけるPIQEの効果

図4 PIQEによる三叉神経の描出

図5 ダイナミックスタディにおけるPIQEの効果

図6 頭頸部領域へのPIQEの応用

3.PIQEの利点と課題

PIQEの利点としては,(1) 組織コントラストを確保しながら空間分解能を向上,(2) PIとも併用可能,(3) 多くの撮像部位やシーケンスで使用可能,などがある。

一方,課題としては,再構成マトリックスに上限があることと,データ容量が非常に大きいことが挙げられる。

まとめ

AiCEを用いることで,画像ノイズを低減し,SNRを向上できるほか,CSやFast 3D modeと併用したHybrid DLRによってSNRを保ったまま高速化 / 高分解能化が可能となる。

また,PIQEによって,組織コントラストを確保しながら空間分解能の向上が可能となる。

*記事内容はご経験や知見による,ご本人のご意見や感想が含まれます。

*AiCE,PIQEは画像再構成処理の設計段階でDeep Learning技術を用いており,本システム自体に自己学習機能は有しておりません。

●参考文献

1)Kidoh, M., et a., Magn. Reson. Med. Sci., 19(3) : 195_206, 2020.

2)Uetani, H., et al., Neuroradiology, 63(1) : 63-71, 2021.

3)Yasaka, K., et al., Jpn. J. Radiol., 40(5) : 476-483, 2022.

4)Uetani, H., Hirai, T., et al., Eur. Radiol., 32(7) : 4527-4536, 2022.

5)Shiraishi, K., et al., Eur. Radiol., 2023(in press).

- 【関連コンテンツ】